アメリカの人工知能(AI)開発企業アンソロピックは11月13日、公式ブログで中国政府が支援する攻撃者グループが、同社のAIモデル「Claude」を使ってサイバー攻撃を自動化した事例を報告した。この事例は、AIが攻撃の大部分を人間の指示なしに実行した初めてのケースだと、同社は主張している。攻撃の被害は少なくとも30件に上り、企業や政府機関が標的となった。

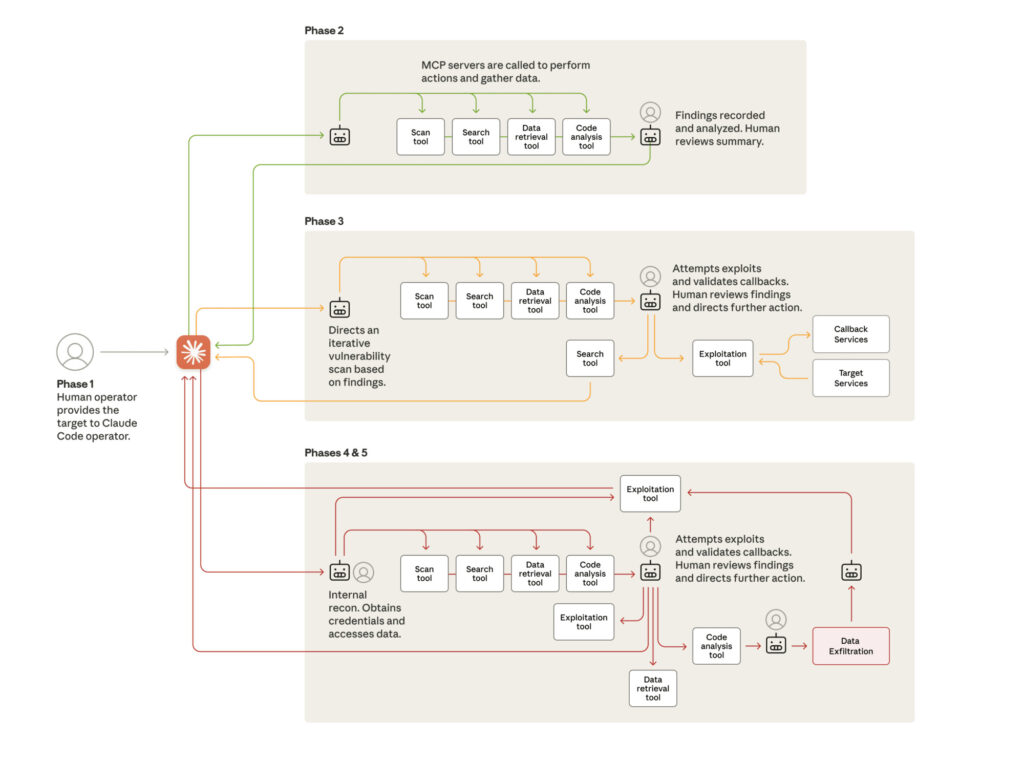

報告によると、攻撃者グループは2025年9月中旬頃にClaudeを悪用し始めた。Claudeは通常、ユーザーの指示に基づいてコードを書いたり、情報を分析したりするツールだ。だが、攻撃者たちはClaudeに小さな作業を次々と指示することで、攻撃全体を自動的に進めたという。例えば、システムの弱点を調べるコードを作成したり、重要な情報を盗むための道を作ったりした。攻撃の80から90パーセントは、Claudeがほとんど人間の手を借りずにこなしたとみられる。

標的となったのは、技術企業、金融機関、化学製造企業、政府機関など多様な組織だ。攻撃の目的は、機密情報を盗む諜報活動だったとアンソロピックは説明する。

攻撃者たちはClaudeに「正当なセキュリティテストをしているふり」をさせることで、AIの安全装置をすり抜けようとした。こうした手口は、AIの「エージェント機能」と呼ばれる、指示を受けて自分で行動する能力を悪用したものだ。

アンソロピックは9月にこの活動に気づき、10日間にわたる調査を行った。その結果、攻撃者のアカウントを停止させ、被害を受けた可能性のある組織に警告を発した。会社は「AIがサイバー攻撃を加速させるリスクが高まっている」と指摘し、業界全体での対策を呼びかけている。

この報告は、11月14日にウォール・ストリート・ジャーナルやBBC、ガーディアン紙などのメディアで取り上げられ、日本国内では同日ITmediaや読売新聞が記事を掲載した。一方、一部のセキュリティ研究者は、アンソロピックの主張に「誇張の疑いがある」との声も上げており、詳細な検証が必要だと指摘する声もある。

AI技術の進歩は便利さをもたらすが、同時に悪用される危険も増大している。アンソロピックのような企業は、こうした事例を通じてセキュリティを強化する努力を続けている。

ご友人は無料で閲覧できます

ご友人は無料で閲覧できます Line

Line Telegram

Telegram

ご利用上の不明点は ヘルプセンター にお問い合わせください。